智算中默算力池化本事深度分析答复

智能算力,东谈主工智能基石,助力构建多要故友融信息基础设施。动作数字经济高质料发展中枢引擎,智能算力基础设施开采正迎来热潮。

智算中心,动作集约化算力基础设施,以智能算力为中枢,包括GPU、AI芯片等,提供全栈软硬件环境。奋力于承载模子素质、推理及多媒体渲染等业务,助力千行百业竣事数智化转型升级。

算力池化本事是一种新式的资源顾问本事,它不错将不同类型的算力团员在沿途,竣事敏捷化资源顾问。这种本事不错使资源得到极致利用,提高合座遵守。

为深化产业共鸣,推动算力池化本事熟谙,中国出动发布白皮书。分析智能算力趋势及挑战,讲述算力池化界说、指标、架构、要道本事及业界探索现实。命令加强相助,共同构建扶持圭表体系。

1. 算力池化本事布景

在数字经济期间,东谈主工智能正深刻地改造咱们的坐蓐、生存花样。跟着聪敏城市、聪敏交通、聪敏家庭等智能场景的渐渐落地,5G、边际计较等撑持本事的连续发展,数智业务转型过程中所产生的数据量正在以愈加难以计量的速率爆发。

证明IDC的《数据期间2025》答复,从2016年至2025年,全球总额据量将激增10倍,达到163ZB。其中,非结构化数据占比超越70%,计较模式日益复杂,对智能算力需求束缚攀升。智能计较将成为主流计较形态。

智能计较正世俗渗入到坐蓐生存的各个界限,智算中心渐渐成为主流算力形态,以GPU、AI芯片为资源。列国政府积极布局AI全栈智商,投资智能算力基础设施开采。我国已步入智能化期间,“十四五”期间,联系部委奋力于推动智算中心开采,为东谈主工智能场景提供大众算力做事。

跟着基础通用大模子业务的引爆,如ChatGPT等,对GPU的市集需求激增,导致“一芯难求”,GPU价钱暴涨。以英伟达A800为例,近半年来价钱增幅高达30%以上。如安在有限的资源供应内提高利用率、裁减智算中心TCO,成为智算中心开采待处分的要道命题之一。

1.1 传统智算中心存在资源效率问题

1.1.1 GPU 资源利用率不及 30%

刻下,智算中心的开采主要由国度或地点政府主导,同期,AI应用做事企业也在积极布局自有智算基础设施。但是,公开数据暴露,传统模式下的智算中心GPU利用率并不睬思,平均数值低于30%。

传统智算中心的 GPU 资源利用率过低,主要开端于以下多个方面的原因:

资源设立尚显毛糙:刻下主要以整卡分拨为主,辅以凭空化分拨花样。这种粗粒度的设立花样难以欢腾不同AI任务的个性化需求,导致部分资源未能充分知道作用,影响算力资源的灵验利用。

(二)算力后劲未充分知道:由于AI任务模子臆想打算劣势、算力优化不及以及模子框架与底层芯片适配不完善等成分,可能导致算力资源性能未能达到最好状态,从而产生独特的资源损耗。

智算中心设备和做事器之间的通讯需要耗尽集结带宽,集结瓶颈会影响影响合座性能,算力资源舒服度高、利用率低。 为了处分这个问题,一些企业或机构正在积极参预自研 RDMA 公约栈及无损集结联系本事。

传统智算中心的 GPU 资源利用率问题是一个玄虚性的问题,需要从资源顾问战术、硬件架构臆想打算、应用软件算法优化等多方面共同优化处分。其中,尤以资源顾问战术方面的优化可控性强、收效快、参预产出比高,是新式智算中默算力池化的报复商议标的之一 。

1.1.2 资源碎屑化导致分拨率低

好的,我不错帮你优化这篇著作。以下是我优化后的著作:

资源碎屑是指体量较小、低于应用需求而无法被分拨出去的闲置资源。连年来,跟着AI业务的飞速发展,从素质到推动,从小模子到大模子,AI任务的种类越来越多,对算力的需求也越来越高。因此,算力资源碎屑化趋势较为昭着。

但愿此次修改概况欢腾你的需求。如果你还有其他问题或需要匡助,请随时告诉我。

(一)任务类型种种化:智算中心的算力资源世俗应用于各种任务,涵盖机器学习、深度学习、图像处理等界限。包括大型、袖珍模子,散布式推理及连合式推动等。由于任务类型的差异性,对硬件设立需求互异,因此不同任务需适配不同的算力资源,竣事充分适配。

(二)任务范围差异:不同范围的任务需求不同算力资源,且无扶持分拨圭表。小范围任务可肯求大算力,加快完成;大范围任务则利用有限资源,裁减投资。这种多成分导致任务规格与硬件设立无法匹配,进而产生算力资源碎屑化。

(三)任务优先级的差异:种种任务可能具有不同的优先级,高优先级任务可能导致计较资源弥留,从而影响低优先级任务的推论和合座资源分拨。

好的,我不错帮您优化著作内容。以下是优化后的著作:

证明种种化 AI 任务对算力资源的差异化需求,纯真地调度、分拨资源,是裁减智算中默算力资源碎屑的要道。

优化后的著作愈加精炼明了,同期保留了原文中的数据和重心信息。如果您有其他需要,请告诉我。

1.2 池化本事是提高资源效率的要道

怎么最大化利用稀缺且高价值的计较资源,并裁减无法分拨的碎屑可能性?一种可能的处分决策是模仿云计较的理念,将GPU、AI芯片等团员到池化资源中。通过独揽先进的资源顾问本事,咱们不错对这些资源进行切分、调度和分拨,从而竣事按任求本色需求的有序供应。

物理成池:借助高性能智算中心集结,竣事做事器间通路的买通,让分散在各做事器的CPU、GPU、AI芯片等算力资源互联互通、透明分享。这项本事糟塌了跨用户、用例、时间模范的资源分享壁垒,为单个AI任务在集群节点中推论提供任性调用集群中算力的便利,进一步教学AI任务的运行速率。

(二)逻辑成池:利用池化软件对 CPU、GPU、AI 芯片等资源在逻辑上团员,AI 任务在创建时,不再是将零碎的、孤岛式的资源进行裸分拨,而是证明调度经过,从团员的池化资源中切分出所需数目进行分拨。一方面,分拨的资源数目可按 AI 任求本色所需推论,当 AI任务所需资源不解确,或因负载变化导致资源数目变动时,可竣事动态供给、回收,竣事多 AI 任务的峰谷互补,裁减资源闲置率;另一方面,切分后的零碎资源不错再度团员、调度、分拨,裁减碎屑率。

2. 算力池化界说与指标

2.1 算力池化的界说

智能算力池化本事是一种依托云计较本事,整合GPU/AI芯片等异构算力资源,构建连合顾问的资源池,并按表层智算业务的需求,对池化的资源进行扶持调度、分拨,竣事智算业务人命周期顾问的全套本事。

为处分智算中心所靠近的资源利用率问题,算力池化基于传统云计较本事(如 Kubernetes、OpenStack,智算中心以 Kubernetes 为主)有针对性地增强 GPU/AI 芯片池化智商,选拔软件界说的花样,对 GPU/AI 芯片进行分时调度顾问,竣事按 GPU/AI 芯片的细粒度分拨资源,并选拔 GPU/AI 芯片 Runtime API 劫持、应用法子监视器等本事,竣事资源跨节点云尔调用、零碎资源整合等,从而达到算力资源充分利用、碎屑最小化成果,可灵验教学资源效率,裁减智算中心合座开采老本。

2.2 算力池化的指标

智能算力池化的指标是利用软件界说本事,对通过高速无损集结互连互通的 CPU、GPU、AI 芯片等算力资源进行池化整合,竣事资源的连合调度、按需分拨,使能资源可被充分利用,裁减碎屑概率,提高总体灵验算力、裁减智算中心购置老本。

好的,我不错帮您优化著作内容。以下是我忽视的优化版块:

化整为零,矫正传统的分拨花样,竣事雅致化分拨智商。证明AI任务的资源需求进行按需供给,欢腾种种化业务的差异需求。

这么的优化版块愈加精炼明了,同期保留了原文中的中枢信息。但愿这不错帮到您!

"最初节点,利用高速无损集结,咱们竣事智能算力的高效调用。CPU 与 GPU、AI 芯片的协同责任得以竣事,从而权贵教学了合座性能并裁减了碎屑化景象。"

立异资源分拨花样,搁置静态与腹地绑定,竣事动态调治与回收。在多任务间竣事峰谷互补,全局资源约束超分,从而提高资源利用效率。

3. 算力池化架构与要道本事

3.1 算力池化平台本事架构

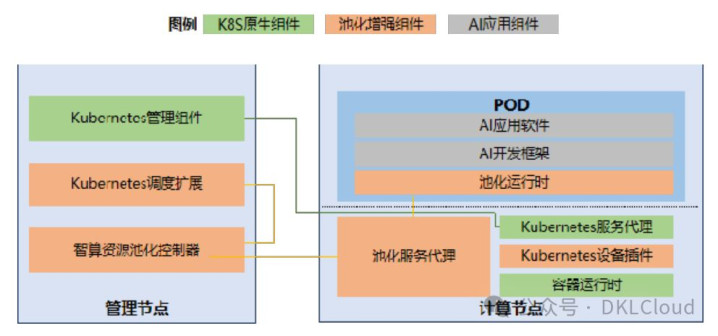

新式智算中默算力池化平台是一种基于云计较本事的推广池化智商,证明AI任务本性,一般基于K8S(Kubernetes)定制化竣事。该平台的本事架构参考如下:

- 新互联:通过高速计较总线、全调度以太网、全绽放DPU、多公约交融存储、全局扶持存储等花样,竣事集结的高速连接和数据的安全传输。

- 新算效:通过算力原生、智算资源池化、散布式素质等花样,提高算力的利用率和效率。

- 新存储:通过多公约交融存储、全局扶持存储等花样,提供高效可靠的数据存储做事。

- 新平台:通过K8S等容器化本事,竣事平台的快速部署和弹性伸缩。

- 新节能:通过智能节能本事,竣事数据中心的绿色运营。

图 1 算力池化平台本事架构

算力池化平台逻辑上可分为池化资源顾问、资源做事代理、池化运行时三类模块构成:

(1) 池化资源顾问

Kubernetes顾问组件:专为欢腾您的需求而臆想打算,提供原生做事组件的增强功能。散布式文献存储、支持多集结平面的POD以及RoCEv2/Infiniband集结等,一切尽在掌执。

Kubernetes调度推广:联系Kubernetes调度做事推广专用的池化资源类型,竣事对这类资源的智能调度与分拨。为充分知道其效用,需与Kubernetes设备插件协同使用。

− 智算资源池化约束器:对 GPU、AI 芯片等智算进行扶持顾问、调度、分拨;

(2) 资源做事代理

池化做事代理:证明智算资源池化约束器的调度,将池化运行时的资源请求重定向至本色物理位置。若波及跨机造访智算资源,需通过池化做事代理屡次重定向,跨机流量通过高速无损集结(如参数面集结)。

Kubernetes 做事代理是基于 Kubernetes 原生做事代理组件定制化增强的。kube-proxy 的作用主若是认真 service 的竣事,具体来说,等于竣事了里面从 pod 到 service 和外部的从 node port 向 service 的造访。

"Kubernetes 设备插件:为Kubernetes做事代理注册专用的池化资源类型,以竣事与Kubernetes调度推广的竣工协同。"

(3) 池化运行时

池化运行时是一种基于 GPU 和 AI 芯片原生运行时(如 CUDA Runtime)的二次封装本事。通过 API 劫持和应用法子监视等技巧,将 AI 应用软件和开发框架对算力资源的造访转发至池化做事代理推论。这种运行时位于容器 POD 内,并在容器运行时自动注入。

证明上述本事架构,当 AI 应用编排器通过调用 Kubernetes API创建应用时,可按新增的池化资源类型指定肯求的资源数目(如pool.kubernetes.io/gpu: 1),对该类型资源的肯求会被 Kubernetes调度推广遏制、转递至智算资源池化约束器进行调度,智算资源池化约束器按肯求的资源数目、资源池内舒服资源散布情况进行调度后,将调度收尾反应给 Kubernetes 顾问组件,然后 Kubernetes 顾问组件正常推论 AI 应用的创建经过,由 Kubernetes 做事代理创建最终 POD动作托福物,并通过池化做事代理配合在 POD 中自动注入池化运行时、通过 Kubernetes 设备插件配合在 POD 中插入凭空 GPU。

AI应用的POD在运行时,通过池化运行时造访凭空GPU、推论AI任务。池化运行时遏制对凭空GPU的造访请求,并将其转递给池化做事代理。池化做事代理查询凭空GPU对应的果真智算资源位置和规格,证明查询收尾分拨智算资源并推论AI任务。如果果真的智算资源位于云尔计较节点,腹地池化做事代答理将造访请求转递给云尔计较节点上的池化做事代理处理。联系通讯通过参数面集结进行。

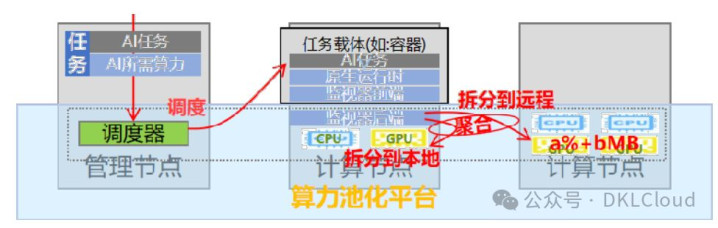

3.2 算力池化本事智商层级

算力池化本事是一种软件界说硬件加快的花样,通过愈加高效纯真的团员、调度以及开释海量 AI 加快算力,精确保险 AI 模子开发、素质、部署、测试、发布全链条算力配给,裁减智算中默算力做事提供老本,教学智算中心合座遵守。

刻下算力池化本事可分为以下三个智商层级:

- 第一层级:基于凭空化的算力池化本事,主要面向异构计较环境,通过凭空化本事竣事对异构计较资源的扶持顾问和调度。

- 第二层级:基于容器化的算力池化本事,主要面向云原生应用场景,通过容器本事竣事对异构计较资源的快速部署和顾问。

- 第三层级:基于硬件抽象层的算力池化本事,主要面向高性能计较场景,通过硬件抽象层竣事对异构计较资源的深度优化和协同责任。

图 2 算力池化本事智商层级

英伟达的 MIG 本事是一种 GPU 凭空化本事,允许一块物理 GPU 被分割成多个寂然的 GPU 实例,每个实例不错被分拨给不同的凭空机、容器或用户。这种本事有助于更灵验地利用 GPU 资源,提高 GPU 的分享性和多佃农支持。

MIG 可将 GPU 辞别为多达七个实例,其中每个实例均透彻寂然,并具有各自的高带宽显存、缓存和计较中枢。如斯一来,顾问员便能支持种种范围的责任负载,确保做事质料 (QoS) 沉稳可靠。

华为云的 AI 芯片动态顾问支持物理 GPU/AI 芯片从算力和显存两个维度纯潜入分,竣事自界说大小(平时算力最小颗粒度 1%,显存最小颗粒度 1MB),欢腾 AI 应用差异化需求。

同期,软件界说 GPU/AI 芯片资源可充分符合刻下应用云原生化趋势,实时反应表层应用对资源需求的变化,竣事 vGPU/AI 芯片资源基于 Scale-Up/Scale-Down 的动态伸缩,并通过资源动态挂载和开释竣事 GPU/AI 芯片资源超分。

阶段 3,池化顾问。池化本事的枢纽突破在于支持 CPU 通用算力及 GPU/AI 芯片等智能算力的寂然成池,两种资源池内汇聚的资源寂然调度、分拨,当调度的资源分属不同节点时,可通过高速无损集结跨节点调用、拼装成 AI 任务所需总算力。此顾问花样下,AI 应用不错部署到智算中心的任性位置,不论所在节点上有莫得智算资源、智算资源够不够,所欠缺的部分从云尔抓取即可,从而竣事在集结范围内充分分享闲置、致使碎屑化的多种类型资源,促进资源的灵验利用。

由于云尔调用的资源造访速率相对较低,因此,池化顾问本事可引入做事质料顾问本事,按任务优先级,优先分拨腹地资源,次选云尔调用。当任务资源不实时,将 AI 任务进行队伍化顾问,恭候开释出实足资源时再运行。这么不错提高系统的沉稳性和性能。

3.3 算力池化要道本事

3.3.1 软件界说的资源分拨花样

传统的依赖于硬件支持的凭空化本事下, AI 应用通过造访GPU/AI 芯片的运行时所提供的接口,以获取对智算资源的调用,资源的算力透彻由卡硬件细目,软件上难以介入,从而无法获取更敏捷的顾问。池化本事下,资源分拨花样发生了根人性的变革,软件介入了资源的算力供给,为开启更敏捷的资源顾问模式,比如动态伸缩、资源超分等奠定了本事基础,为连续优化智算资源利用率创造了无尽可能。池化本当事者要通过以下两种竣事了软件界说的资源分拨:

- 基于容器化的资源顾问

- 基于凭空化的资源顾问

(1) API 劫持本事

API 劫持本事是一种针对智能算力的池化本事,它通过劫持对 Runtime API(如 CUDA API)调用竣事资源调度。

API 劫持本事是一种针对智能算力的池化本事,它不错通过劫持对 Runtime API(如 CUDA API)调用竣事资源调度。

如图3.1所示,AI应用的容器POD内运行的池化运行时并非平直基于GPU/AI芯片原生的运行时。本色上,它是经过一定程度定制的版块,与原生运行时提供透彻等效的API接口。这意味着关于AI应用来说,这种运行时是透明且无感知的。

当AI应用调用池化运行时的API时,这些请求会被池化运行时传递给池化做事代理进行处理。池化做事代理领有高度纯真的资源管奢睿商,举例概况按照1%的算力和1MB的缓存精度进行细粒度的资源分拨。此外,它还能竣事跨节点的云尔资源调度,从而进一步教学了资源利用率和效率。

图 3 API 劫持本事图解

API 劫持本事的要道在于池化运行时仿真 GPU/AI 芯片的原生运行时,由于 GPU/AI 芯片种类、型号众多,其原生运行时又相对活跃、升级时常,仿真责任较为复杂,开发量、谨防难度较大。

(2) 应用法子监视器本事

这是一种透彻与 GPU/AI 芯片无关的设备凭空化和云尔处理要领,允许在莫得显式软件支持的情况下启用新的硬件体绑缚构。该项本事通过应用法子监视器责任,该监视器与 Hypervisor 顾问凭空机的花样相似,分为前端、后端,前端监视指定应用法子的活动,拦甘休后端处理,后端不错按应用法子肯求的数目分拨资源,或将应用法子拆分到多台机器上运行,在保持代码、数据和推论环境一致性的前提下使用这些机器上的智算资源,从而竣事资源的细粒度顾问、云尔调用等资源敏捷化顾问功能。

应用法子监视器认真谨防应用法子状态(内存、文献、应用法子库的加载),以及凭空化与系统的交互(举例系统调用和进度间通讯),以确保在多个位置推论时的一致性。

图 4 应用法子监视器本事图解

应用法子监视器本事邯郸学步,与侵入AI应用资源造访经过的API劫持本事截然相背。它搁置了仿真原生运行时API接口的花样,而是通过底层系统调用,精巧地支持种种硬件和新运行时功能。这种竣事花样与特定运行时API(如CUDA)无关,展现出高大的通用性和兼容性。应用法子监视器本事动作一种新式池化决策,咱们忽视在本事熟谙后再沟通买卖引入。

3.3.2 算力资源高质料顾问本事

(一)资源细粒度分拨

通过凭空化本事,竣事对物理资源的雅致化顾问。在新的体系下,应用不再受限于传统的硬件资源肯求与使用花样,而所以更为纯真的花样进行操作。以算力 1%,显存 1MB 为基本单元,为表层应用提供更为高效的资源利用决策。

(二)资源名额顾问

利用时候算力约束本事,竣事GPU算力和显存在不同佃农、统一佃农内不同进度以及不同佃农之间的阻隔与调控。此举旨在减少资源争夺导致的性能波动,细心法子坏心占用算力资源。

(三)资源无感动态伸缩

池化本事能动态调治资源分拨,欢腾容器的实时需求。表层应用证明业务逻辑和负载景色,向调度平台肯求算力、显存等资源,竣事资源的垂直推广。

(四)资源超分及峰谷互补

为确保做事质料,智算中心在提供各种业务时,选拔分散部署战术。但是,由于业务运行存在岑岭与低谷,导致异构算力硬件在舒服期权贵延迟,远超岑岭期,进而使合座资源利用率裁减。

将业务的波谷时段利用起来,不错减少波谷时间,从时间维度教学遵守;同期,将资源预留冗余松开,不错从空间维度教学遵守。因此,将不同优先级、不同波动周期的业务进行混杂部署,为两个维度教学利用率提供了可能性。这么,低优先级任务就不错占用舒服资源,而高优先级任务则能实时霸占到资源,从而保证要道业务的做事质料。

算力池化本事,通过软件界说,精巧地抽象底层物理硬件资源,竣事范围放大。利用硬件计较周期舒服时间,时候复用算力,最大化资源利用。同期,单一指针顾问内存,竣事显存、系统内存扶持谨防。在CPU与GPU之间建立内存池,分享内存资源,系统自动进行内存迁徙,以拓展GPU显存,如CUDA unified memory。

(五)智算任务队伍化顾问

单个 AI 任务的开展可苟且划为为数据准备、任务推论、模子评估三个阶段,从资源角度上分析,数据准备阶段主要使用 CPU 资源,素质开动后才开动使用 GPU 算力资源进行计较加快。相较于 CPU 通用算力资源,智算中心内智能算力资源愈加容易达到瓶颈,为提高合座AI 素质任务的推论效率,算力池化本事可提供智能算力资源列队的智商,即 AI 任务的下发可证明 CPU、内存等资源的可用情况触发,素质任务进入推论阶段后,如智能算力资源不及可进行列队恭候,次第推论。同期可证明素质任务的报复程度,缔造资源使用的优先级。

3.3.3 泛在化碎屑的池化整合本事

利用泛在化碎屑并将其池化整合,将分散的资源合并为逻辑视图上的一整片算力。这将提高欢腾AI任务资源规格需求的概率。

(一)泛在化资源跨机整合本事

论文《Characterizing Deep Learning Training Workloads onAlibaba-PAI》分析了阿里一个素质集群上的负载特征(见图 5):从任务数目上看,约 59%的任务是单卡小任务;从 GPU 资源耗尽上看,天然 81%的 GPU 是被散布式素质任务占用(单机多卡也算散布式),但是这其中有一半的资源是被小于 8 个 GPU 的任务所占用(1 台物理做事器可欢腾);唯有 0.7%数目的任务是使用超越 128 个 GPU(需要16 台或更多物理做事器)。

这个商议标明,素质任务的种种性和范围差异很大。从资源利用的角度来看,智算中心的种种业务对CPU和GPU的算力需求也呈现出种种性。但是,由于GPU做事器硬件平时设立为单机4卡或8卡,因此在承载种种素质任务时,固定的CPU与GPU配比可能会导致资源碎屑化的问题。这种情况会使得多半的多卡任务因为资源不及而在队伍中列队恭候推论,进而可能导致合座资起源转效率裁减。

为处分资源碎屑问题,池化本事不错竣事对零碎资源的整合,包括跨机整合。见第 3.1章,智算资源池化约束器竣事了对 CPU及 GPU/AI芯片分池、单独调度,也即为 POD 调度的 CPU 与 GPU/AI 芯片资源可能不在统一台做事器上,但对应用是透明的,当 AI 应用造访凭空 GPU时,由池化做事代理证明凭空 GPU 所对应的果真 GPU 资源位置分拨资源,如果有云尔调用需求,则由 POD 所在做事器上的池化做事代理转发资源请求至指标做事器上的池化代理做事造访。

(二)智算业务 SLA 分级及自动做事质料顾问

动作承载海量智算业务的基础设施,智算中心需在兼顾合座婉曲率与GPU/AI芯片资源利用率的基础上,优化多个素质任务的合座性能,而非过分强调单一任务的性能。

深度学习框架是素质任务的基石,旨在教学性能。池化本事充分利用数据中心资源,竣事多任务最优,与框架指标相得益彰。

通过框架和池化本事的协同优化,咱们能竣事多任务间的资源最优化设立。借助池化本事,咱们不错证明任务的性能需求进行分级顾问,优先分拨硬件资源、使用所在做事器上的GPU/AI芯片资源,或者调治数据中心内可用的算力资源。这么,咱们不仅能欢腾各个任务的性能条件,更能达到合座资源的最优化分拨,从而教学计较效率和任务推论速率。

5. 估量与倡议

跟着AIGC产业的欣喜,如GPT和Stable Diffusion等本事的熟谙,智能算力需求呈指数级增长。与传统的GPU/AI芯片纵贯本事比较,算力池化本事具有更高的算力利用效率、浮浅的使用花样和裁减的使用老本,为产业发展奠定坚实的算力基础。

-对此,您有什么概念视力?-

首页

首页